spark submit 运行多个任务问题,求大神解答

0

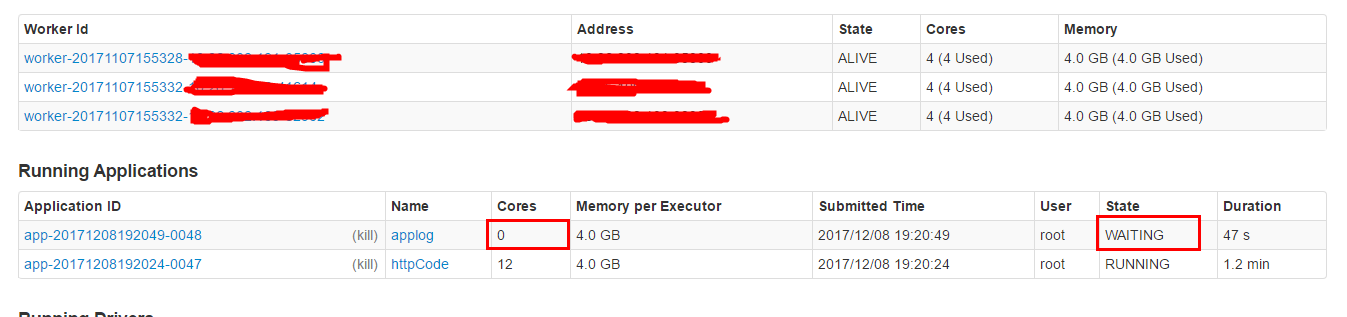

我用的是独立模式,2个application 提交的参数是: --master spark://spark-1:7077 --executor-memory 4g --driver-memory 2g --total-executor-cores 12 --executor-cores 4 ,为什么后面一个application一直处于等待状态?

最佳答案

1

已经解决,妹的机器被挖矿进程占了所有的cpu造成其他进程排队,把挖矿进程解决掉了,后面重新启动第二个spark任务就直接running状态了。

其他回答(1)

0

也能证明一件事,spark的application在向schedulerbackend申请不到core时会等待,等待时间相比应该会有个默认值