我爬到了图片url,但不知道如何保存,并给这些文件取个随机名字。

import requests

url = 'https://www.pixiv.net/ranking.php?mode=daily'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 '

'(KHTML, like Gecko) Chrome/45.0.2454.101 Safari/537.36'}

date = 20190416

for p in range(1,6):

params = {'date':str(date),'p':str(p),'format':'json'}

Page = requests.get(url, params=params, timeout=2, headers = headers)

cont = Page.json()['contents']

urls = [g['url'] for g in cont]

for link in urls:

print(link)

目前我能明白要带referer的header去下载,但不知道该如何实现

用requests访问这些link,获得返回的content,存二进制

for link in urls:

print(link)

response = requests.get(link, params=params, timeout=2, headers=headers)

content = response.content

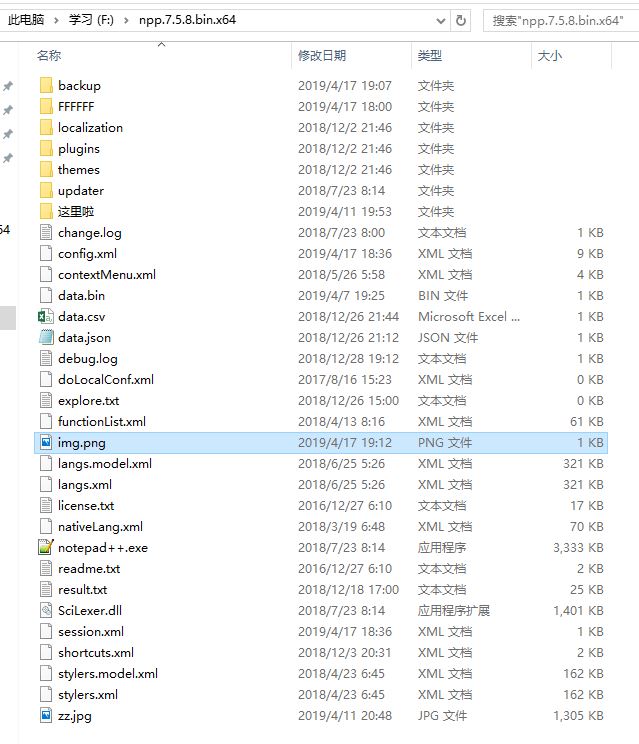

with open('img.png', 'wb+') as img:

img.write(content)

不知道是不是你错了,我认为你这样只能保存一张img.png的图,后面的文件都取了相同的名字,我觉得应该创个文件夹,命名方式用random模块取一个1-50数字来当名字,后缀全改为png如(1.png)

@luckytownL: 我只是举个例子,这个是只能保存一张,会被覆盖,随机的名字要你自己写的。

@luckytownL: 而且这个代码我没跑,你要用的话可能要改...因为你的URL我访问不了

@Masako: 没事,就想问问。既然你这么说,我就继续试试能不能按这种想法来保存了。

@luckytownL: 嗯嗯,你这个没什么问题。

curl可以解决

没怎么听过,所以不会用 = =

func(){

lock

{

guid

}

}