mysql navicat 运行sql脚本,4个G

0

[已解决问题]

解决于 2018-01-05 09:10

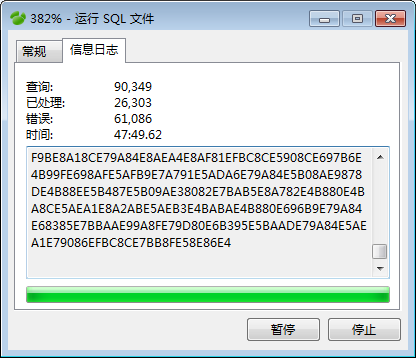

大小4个G.用source命令试过,cmd会直接卡死。所以就用Navicat,结果目前是这个样子:

正常吗?

最佳答案

0

http://www.cnblogs.com/zjfblog/p/8143012.html

其他回答(5)

0

运行脚本的电脑什么配置?

8G内存,I5处理器

@jiafeng: 这个主要看硬盘的速度

@dudu: 搜嘎

0

明显不正常啊

恩

0

这种大量数据的话最好那脚本来跑比较好吧,然后记录一下错误然后跳过该条,或者遇见错误就清空停止,

恩,我再试试

0

mysql只能通过脚本备份导出导入数据么

貌似是的~好像没有类似sqlserver那种的bak或者mdf/ldf文件

0

可以用mysql自带的source导入大量数据,很快,不会卡死的吧,可以试下mysqldump重新导出一份跳过错误,在用source导入

机器重启,删库,重新弄了一下,好像可以了,用source跑,都跑了块两三个小时了,还在跑