使用scrapy-redis进行分布式爬虫时,发现用2台电脑爬取数据时,一台能爬而另一台不能爬

0

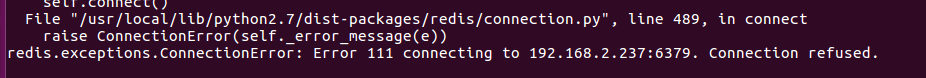

使用scrapy-redis进行分布式爬虫时,发现用2台电脑爬取数据时,一台能爬而另一台不能爬。如果只使用单独一台都可以爬,但同时一起爬就只能有一台可以爬取,另外一台不能爬取,不能爬取是报错如下:

最佳答案

0

原因为settings.py文件里面的异步请求数CONCURRENT_REQUESTS设置过大导致的

Configure maximum concurrent requests performed by Scrapy (default: 16)

CONCURRENT_REQUESTS

其他回答(2)

0

redis没连上啊。

你是把redis放在采集的机器上了吗?

先测试一下这台机器能不能连另一台的redis哦。

收获园豆:30

现在2个爬虫端都可以连接redis数据库,但问题仍旧没有解决

上面图片连接拒绝是用ubuntu爬虫端爬取完数据时出现的,但我用windows爬虫端却一直没能爬取

0

master上开Redis数据库, slave连接master上的Redis数据库,而数据爬取全部由slave去做,master负责监控就好

收获园豆:20

谢谢,已经解决了。原因是2个爬虫端的设置异步请求数过大导致的。