JMeter 聚合报告中的Average和Throughput指标之间的关系和区别???

最近在学习JMeter。但是对Average和Throughput这两个指标不太理解

查阅资料,对这两个指标的定义是:

Average:平均响应时间——默认情况下是单个 Request 的平均响应时间,当使用了 Transaction Controller 时,也可以以Transaction 为单位显示平均响应时间

Throughput:吞吐量——默认情况下表示每秒完成的请求数(Request per Second),当使用了 Transaction Controller 时,也可以表示类似 LoadRunner 的 Transaction per Second 数

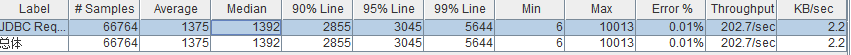

我的疑问1:吞吐量=202.7/sec 我的理解是--每秒处理202.7个请求

Average=1375 我的理解是--处理完一个请求的平均时间:1375ms=1.375s 那么1s就只能处理一个请求。 那为什么吞吐量又是1s处理202.7个请求????

我的疑问2: 在测试过程中,Samples数一样。在测试不同的系统中,为什么有的吞吐量大的,Average反而也很大。比如如列所示:

系统1: samples :4000 Average:60 Throughput:600/sec

系统2: samples :4000 Average:20 Throughput:200/sec

不知道耶

Average=1375 这个的意思可以理解为一个线程处理完一个请求的平均时间:1375ms=1.375s

而这个202.7/sec 就是一秒中可以处理202.7个请求 ,为什么会这样呢?因为你每秒钟会启动很多线程,每个线程都有可能完成一个请求,所以当线程数足够多的情况下就会有这样的结果

问题是这个线程数是多少,而且线程数并不一定是并发数,这个不能这么果断吧,如果并发数并不高,那出来的这个结果怎么解释呢